Neuartige Eingabegeräte

Entstehung neuer Eingabegeräte

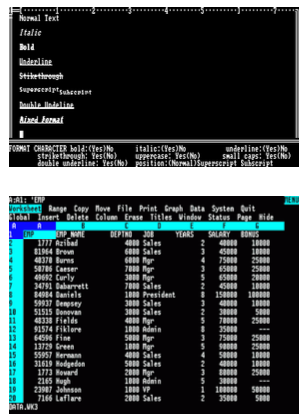

Anfängliche Interfaces rein text-basiert

Navigation mit Tastatur

Zusatztasten, Meta/Modifiertasten

Optimiert auf Texteingabe

Sehr effizient

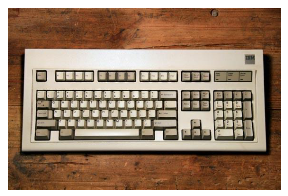

Geringe Modifikationen über die Zeit

Leichter Einstieg und Vertrautheit

Maus

Interface Konzept zugschnitten auf die Möglichkeiten der Maus

Verschiedene Ausprägungen

- Etablierte Varianten übersichtlich

- Maustasten

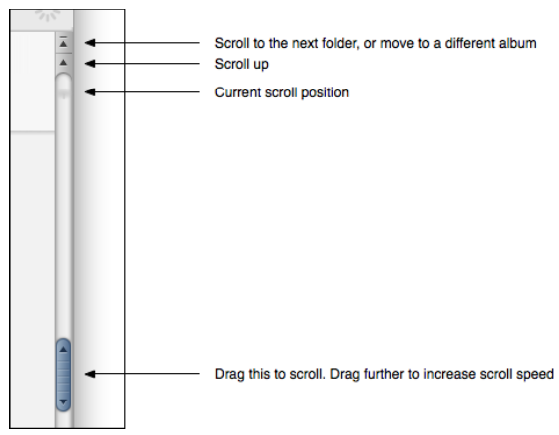

Etablierung der Maus hat Scroll-Lock überflüssig gemacht

Heute etablierte Eingabegeräte

- Verbreitet

- Tastatur, Maus, Touch, (Sprache)

- Spezialaufgaben

- Joystick, Gyro/Space Maus, Stylus…

- Innovationen

- Wii, Kinect, PS Move/Eye…

Neuartige Eingabegeräte

- CLI = Command Line Interface

- Formalisiert

- Experten, steile Lernkurve

- GUI = Graphical User Interface

- Methaphorisch

- Normaler Benutzer, explorative Lernkurve

- NUI = Natural User Interface

- Intuitiv

- Gelegenheitsnutzung, (idealerweise) keine Lernkurve

- Menscherfassung

- Erfassungstechnologie

Menschliche Sinne

“Welche Sinne benötigt ein Computer ?” “Wie lassen sich die benötigten Sinne im Computer abbilden ?”

Sehen

Sakkaden: Blicksprünge

- bewusst (z.B. Lesen) und unbewusst

- Während einer Sakkade werden keine Informationen aufgenommen (saccadic suppression)

- Die Augen bewegen sich bis zu 1000 Grad / s

Fixation: Das Verweilen des Blicks an einem Punkt\

- Übliche Fixationsdauer : 50 bis 800 Millisekunden

Dreidimensionales Sehen

Beide Augen sehen das gleiche Objekt aus leicht anderem Winkel (Disparität)

Winkel ist abhängig von der Entfernung

Indikatoren für Tiefe

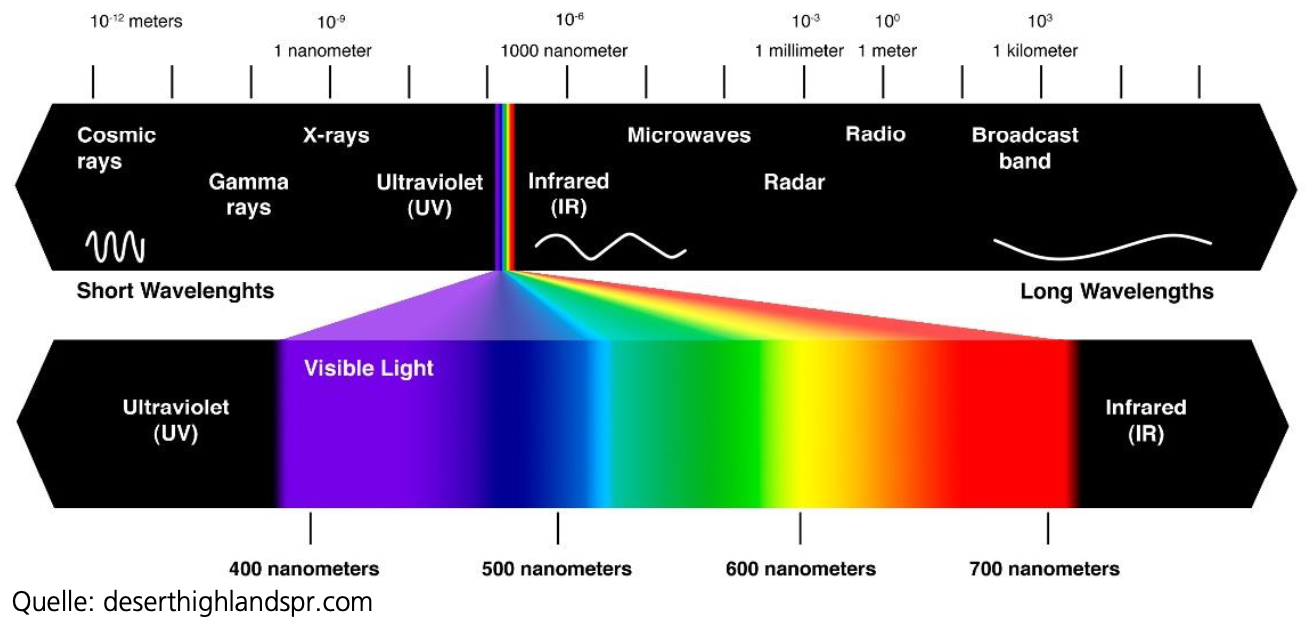

Farbspektrum

Sichtbares Licht ist ein kleiner Teil des elektromagnetischen Spektrums

Hören

Schall

- Der wahrnehmbare Frequenzbereich liegt zwischen 16 und 20000 Hertz

- Wahrnehmung ab einer Lautstärke von 0 bis 10 dB

- Ausbreitungsgeschwindigkeit ca. 343 m / s

Lokalisation

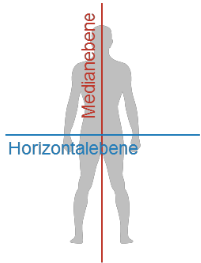

Bei der Bestimmung der Richtung und Entfernung einer Schallquelle unterscheidet man zwischen der Horizontalebene und der Medianebene

- in der Horizontalebene durch binaurales Hören

- Messen durch Laufzeitunterschiede zwischen beiden Ohren

- Unter 80Hz keine Lokalisierung möglich

- in der Medianebene durch Resonanzanalyse

- Außenohr wirkt als richtungsselektiver Filter

- Je nach Einfallsrichtung Anregung verschiedener Resonanzen

- in der Horizontalebene durch binaurales Hören

Bestimmung der Entfernung nur relativ ungenau möglich durch

- Veränderung des Frequenzspektrums je nach Entfernung (weiter entfernten Schallquellen fehlen die hohen Frequenzanteile)

- Lautstärkeveränderung oder bekannte Schallquellen

- Schallreflexionen

- Bewegungsparallaxe

Tasten

- „Tasten“ kann verschiedene Eigenschaften von Oberflächen erfassen

- Spezielle Rezeptoren für verschiedene Eigenschaften

- Anders als bei Hören und Sehen wenig Analogien bei der Erfassung durch einen Compute

Riechen & Schmecken

- Generierung und Analyse sehr komplex

- Kaum Einsatz im Bereich der der Mensch-Maschine-Interaktion 🤪

Multimodale Interaktion

Modalität

- Ein Kommunikationssystem

- Abgrenzung durch die Art der Übertragung und Kodierung von Informationen

Menschen kommunizieren multimodal

- Kombination mehrerer Modalitäten

Vorteile multimodaler Kommunikation

- Redundanz reduziert Fehler –> Robustheit

- Beste Modalität je nach Information –> Effizienz

- Anpassung an Partner/Umgebungseigenschaften –> Flexibilität

Neben den Vorteilen führt die multimodale Mensch-Mensch Kommunikation dazu, das multimodale Mensch-Computer Schnittstellen natürlich wirken !

Erfassung des Menschen

- Position

- Identität, Alter, Geschlecht, Mimik Handgesten

- Körperpose

- Kopforientierung

- Sprache

- Blickrichtung

Optisch non invasiv

Personentracking

- Grundlage für weitere Komponenten

- Viele verschiedene Ansätze

- Detektoren für Köpfe und Oberkörper

- Vordergrundsegmentierung

- Berücksichtigung von Farbe und Textur von Kleidungen

Bodytracking, Kinect (ONE), Xtion, TOF

- 3D Verfahren dominant

- Extraktion eines Skelettmodell

- Verhaltensanalyse

- Zeigegesten

- Direkte Interaktion

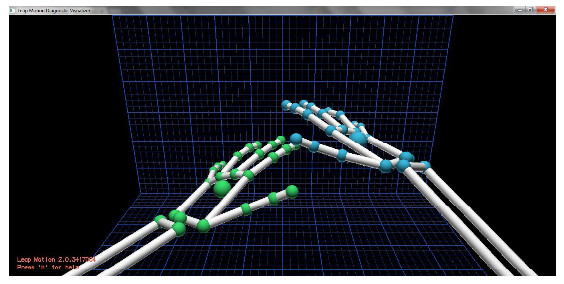

Handtracking

Hangesten sind mächtiger als Zeigegesten

👍 Vorteil visueller Erkennung

- Interaktion nur bei valider Geste

- Touchscreens interpretieren jedes Aufstützen als Eingabe

- Personenbezogene Gestenfunktionalität

- Berücksichtigung der z-Achse

Leapmotion

Gesichtsanalyse

- Identität

- Alter

- Geschlecht

- Qualität besser bis vergleichbar zu Menschen

Blickmessung

- Aufbau: IR Kamera(s) & Strahler

- Extraktion von Pupille & IR Reflexionen

- Kalibrierung auf Monitor

Kopfdrehung

- Grobe Annäherung für Blick

- Ableitung der Aufmerksamkeit

- Aus größerer Entfernung möglich

- Automatische Generierung eines Kopfmodels

- Tracking des Kopfmodells (ICP)

- Generierung neuer Modelle zur Laufzeit

- Hohe Genauigkeit & Robustheit

Optisch

- Vicon

- Oculus Rift (Devkit2+)

Nicht optisch

- Ubisense

- Lighthouse

- MyoMotion

- Myo Armband

- Oculus Rift (Devkit1) Spracherkennung

🔭 Ausblick

- EEG Interfaces

- Hauptsächlich für Menschen mit Behinderungen

- Neue Umgebungen erfordern neue Eingabegeräte