Zweidimensionale Zufallsvariable Verteilungsfunktion und Dichte Eine vektorwertige Funktion

X ‾ = X ‾ ( ω ) : Ω → R 2

\underline{X}=\underline{X}(\omega): \Omega \rightarrow \mathbb{R}^{2}

X = X ( ω ) : Ω → R 2 die jedem Ergebnis ω ∈ Ω \omega \in \Omega ω ∈ Ω x ‾ = [ x 1 x 2 ] \underline{x}=\left[\begin{array}{l}x_{1} \\ x_{2}\end{array}\right] x = [ x 1 x 2 ] mehrdimensionale Zufallsvariable I a ‾ = ( − ∞ , a 1 ] × ( − ∞ , a 2 ] ⊂ R 2 I_{\underline{a}}=\left(-\infty, a_{1}\right] \times\left(-\infty, a_{2}\right] \subset \mathbb{R}^{2} I a = ( − ∞ , a 1 ] × ( − ∞ , a 2 ] ⊂ R 2

X − 1 ( I a ) ∈ B , ∀ a ‾ ∈ R 2 .

X^{-1}\left(I_{a}\right) \in \mathfrak{B}, \quad \forall \underline{a} \in \mathbb{R}^{2}.

X − 1 ( I a ) ∈ B , ∀ a ∈ R 2 . Verteilungsfunktion Die Funktion

F X ‾ ( x ‾ ) = F X 1 , X 2 ( x 1 , x 2 ) = P ( X 1 ≤ x 1 , X 2 ≤ x 2 )

\begin{aligned}

F_{\underline{X}}(\underline{x}) &=F_{X_{1}, X_{2}}\left(x_{1}, x_{2}\right) \\

&=\mathrm{P}\left(X_{1} \leq x_{1}, X_{2} \leq x_{2}\right)

\end{aligned}

F X ( x ) = F X 1 , X 2 ( x 1 , x 2 ) = P ( X 1 ≤ x 1 , X 2 ≤ x 2 ) der zweidimensionalen Zufallsvariablen X ‾ \underline{X} X Verteilungsfunktion X ‾ \underline{X} X

Dichte Die Dichte X ‾ \underline{X} X F X ‾ ( x ‾ ) F_{\underline{X}}(\underline{x}) F X ( x )

f X ‾ ( x ‾ ) = f X 1 , X 2 ( x 1 , x 2 ) = ∂ 2 ∂ x 1 ∂ x 2 F X 1 , X 2 ( x 1 , x 2 )

f_{\underline{X}}(\underline{x})=f_{X_{1}, X_{2}}\left(x_{1}, x_{2}\right)=\frac{\partial^{2}}{\partial x_{1} \partial x_{2}} F_{X_{1}, X_{2}}\left(x_{1}, x_{2}\right)

f X ( x ) = f X 1 , X 2 ( x 1 , x 2 ) = ∂ x 1 ∂ x 2 ∂ 2 F X 1 , X 2 ( x 1 , x 2 ) Sind beide Komponenten diskret verteilt, schreibt man für deren „Dichte“

f X ‾ ( x ‾ ) = ∑ n = 1 ∞ ∑ k = 1 ∞ P ( X 1 = x 1 , n , X 2 = x 2 , k ) ⋅ δ ( x 1 − x 1 , n , x 2 − x 2 , k )

f_{\underline{X}}(\underline{x})=\sum_{n=1}^{\infty} \sum_{k=1}^{\infty} \mathrm{P}\left(X_{1}=x_{1, n}, X_{2}=x_{2, k}\right) \cdot \delta\left(x_{1}-x_{1, n}, x_{2}-x_{2, k}\right)

f X ( x ) = n = 1 ∑ ∞ k = 1 ∑ ∞ P ( X 1 = x 1 , n , X 2 = x 2 , k ) ⋅ δ ( x 1 − x 1 , n , x 2 − x 2 , k ) mit der zweidimensionalen δ \delta δ δ ( x 1 , x 2 ) \delta(x_1, x_2) δ ( x 1 , x 2 ) P ( X 1 = x 1 , n , X 2 = x 2 , k ) \mathrm{P}\left(X_{1}=x_{1, n}, X_{2}=x_{2, k}\right) P ( X 1 = x 1 , n , X 2 = x 2 , k )

Randdichten und bedingte Dichten X ‾ \underline{X} X f ( X ‾ ) = f X ‾ ( x 1 , x 2 ) f(\underline{X})=f_{\underline{X}}\left(x_{1}, x_{2}\right) f ( X ) = f X ( x 1 , x 2 )

f X 1 ( x 1 ) = ∫ − ∞ ∞ f X ‾ ( x 1 , x 2 ) d x 2 f X 2 ( x 2 ) = ∫ − ∞ ∞ f X ‾ ( x 1 , x 2 ) d x 1

\begin{array}{l}

f_{X_{1}}\left(x_{1}\right)=\int_{-\infty}^{\infty} f_{\underline{X}}\left(x_{1}, x_{2}\right) \mathrm{d} x_{2} \\

f_{X_{2}}\left(x_{2}\right)=\int_{-\infty}^{\infty} f_{\underline{X}}\left(x_{1}, x_{2}\right) \mathrm{d} x_{1}

\end{array}

f X 1 ( x 1 ) = ∫ − ∞ ∞ f X ( x 1 , x 2 ) d x 2 f X 2 ( x 2 ) = ∫ − ∞ ∞ f X ( x 1 , x 2 ) d x 1 Randdichten X X X

X X X f X ( x 1 , x 2 ) f_X(x_1, x_2) f X ( x 1 , x 2 ) f X 1 ( x 1 ) > 0 f_{X_1}(x_1) > 0 f X 1 ( x 1 ) > 0 f X 2 ( x 2 ) > 0 f_{X_2}(x_2) > 0 f X 2 ( x 2 ) > 0

f X 1 ( x 1 ∣ X 2 = x 2 ) = f X ‾ ( x 1 , x 2 ) f X 2 ( x 2 )

f_{X_{1}}\left(x_{1} \mid X_{2}=x_{2}\right)=\frac{f_{\underline{X}}\left(x_{1}, x_{2}\right)}{f_{X_{2}}\left(x_{2}\right)}

f X 1 ( x 1 ∣ X 2 = x 2 ) = f X 2 ( x 2 ) f X ( x 1 , x 2 ) die bedingte Dichte X 1 X_1 X 1 X 2 = x 2 X_2 = x_2 X 2 = x 2

f X 2 ( x 2 ∣ X 1 = x 1 ) = f X ‾ ( x 1 , x 2 ) f X 1 ( x 1 )

f_{X_{2}}\left(x_{2} \mid X_{1}=x_{1}\right)=\frac{f_{\underline{X}}\left(x_{1}, x_{2}\right)}{f_{X_{1}}\left(x_{1}\right)}

f X 2 ( x 2 ∣ X 1 = x 1 ) = f X 1 ( x 1 ) f X ( x 1 , x 2 ) ist die bedingte Dichte von X 2 X_2 X 2 X 1 = x 1 X_1 = x_1 X 1 = x 1

Formel von der totalen Wahrscheinlichkeit für Dichten

f _ X _ 1 ( x _ 1 ) = ∫ _ − ∞ ∞ f _ X _ 1 ( x _ 1 ∣ X _ 2 = x 2 ) f _ X _ 2 ( x _ 2 ) d x _ 2

f\_{X\_{1}}\left(x\_{1}\right)=\int\_{-\infty}^{\infty} f\_{X\_{1}}\left(x\_{1} \mid X\_{2}=x_{2}\right) f\_{X\_{2}}\left(x\_{2}\right) \mathrm{d} x\_{2}

f _ X _ 1 ( x _ 1 ) = ∫ _ − ∞ ∞ f _ X _ 1 ( x _ 1 ∣ X _ 2 = x 2 ) f _ X _ 2 ( x _ 2 ) d x _ 2 Satz von Bayes für Dichten

f _ X _ 2 ( x _ 2 ∣ X _ 1 = x _ 1 ) = f _ X _ 1 ( x _ 1 ∣ X _ 2 = x _ 2 ) f _ X _ 2 ( x _ 2 ) ∫ _ − ∞ ∞ f _ X _ 1 ( x _ 1 ∣ X _ 2 = x _ 2 ) f _ X _ 2 ( x _ 2 ) d x _ 2

f\_{X\_{2}}\left(x\_{2} \mid X\_{1}=x\_{1}\right)=\frac{f\_{X\_{1}}\left(x\_{1} \mid X\_{2}=x\_{2}\right) f\_{X\_{2}}\left(x\_{2}\right)}{\int\_{-\infty}^{\infty} f\_{X\_{1}}\left(x\_{1} \mid X\_{2}=x\_{2}\right) f\_{X\_{2}}\left(x\_{2}\right) \mathrm{d} x\_{2}}

f _ X _ 2 ( x _ 2 ∣ X _ 1 = x _ 1 ) = ∫ _ − ∞ ∞ f _ X _ 1 ( x _ 1 ∣ X _ 2 = x _ 2 ) f _ X _ 2 ( x _ 2 ) d x _ 2 f _ X _ 1 ( x _ 1 ∣ X _ 2 = x _ 2 ) f _ X _ 2 ( x _ 2 ) Der bedingte Erwartungswert X 1 X_1 X 1 X 2 = x 2 X_2 = x_2 X 2 = x 2

E f x ‾ ‾ { X 1 ∣ X 2 = x 2 } = ∫ − ∞ ∞ x 1 f X 1 ( x 1 ∣ X 2 = x 2 ) d x 1

\mathrm{E}_{f_{\underline{\underline{x}}}}\left\{X_{1} \mid X_{2}=x_{2}\right\}=\int_{-\infty}^{\infty} x_{1} f_{X_{1}}\left(x_{1} \mid X_{2}=x_{2}\right) \mathrm{d} x_{1}

E f x { X 1 ∣ X 2 = x 2 } = ∫ − ∞ ∞ x 1 f X 1 ( x 1 ∣ X 2 = x 2 ) d x 1 Unabhängigkeit von Zufallsvariablen Zwei Zufallsvariablen X , Y X, Y X , Y unabhängig

f X , Y ( x , y ) = f X ( x ) ⋅ f Y ( y )

f_{X, Y}(x, y)=f_{X}(x) \cdot f_{Y}(y)

f X , Y ( x , y ) = f X ( x ) ⋅ f Y ( y ) Damit gilt auch

f X ( x ∣ Y = y ) = f X ( x )

f_{X}(x \mid Y=y)=f_{X}(x)

f X ( x ∣ Y = y ) = f X ( x ) Erwartungswert für zweidimensionale Zufallsvariablen:

E f X , Y { g ( X , Y ) } = ∫ − ∞ ∞ ∫ − ∞ ∞ g ( x , y ) f X , Y ( x , y ) d x d y

\mathrm{E}_{f_{X, Y}}\{g(X, Y)\}=\int_{-\infty}^{\infty} \int_{-\infty}^{\infty} g(x, y) f_{X, Y}(x, y) \mathrm{d} x \mathrm{~d} y

E f X , Y { g ( X , Y )} = ∫ − ∞ ∞ ∫ − ∞ ∞ g ( x , y ) f X , Y ( x , y ) d x d y Die Kovarianz σ X , Y = Cov f X , Y { X , Y } \sigma_{X, Y}=\operatorname{Cov}_{\boldsymbol{f}_{X, Y}}\{X, Y\} σ X , Y = Cov f X , Y { X , Y } X X X Y Y Y

σ X , Y = Cov f X , Y { X , Y } = E { ( X − E { X } ) ⋅ ( Y − E { Y } ) } = E { ( X − μ x ) ⋅ ( Y − μ y ) }

\sigma_{X, Y}=\operatorname{Cov}_{f_{X, Y}}\{X, Y\}=\mathrm{E}\{(X-\mathrm{E}\{X\}) \cdot(Y-\mathrm{E}\{Y\})\}=\mathrm{E}\left\{\left(X-\mu_{x}\right) \cdot\left(Y-\mu_{y}\right)\right\}

σ X , Y = Cov f X , Y { X , Y } = E {( X − E { X }) ⋅ ( Y − E { Y })} = E { ( X − μ x ) ⋅ ( Y − μ y ) } Der Korrelationskoeffizient von X X X Y Y Y

ρ X , Y = Cov f X , Y { X , Y } Var f X { X } Var f Y { Y } = σ X , Y σ X ⋅ σ Y ∈ [ − 1 , 1 ]

\rho_{X, Y}=\frac{\operatorname{Cov}_{f_{X, Y}}\{X, Y\}}{\sqrt{\operatorname{Var}_{f_{X}}\{X\} \operatorname{Var}_{f_{Y}}\{Y\}}}=\frac{\sigma_{X, Y}}{\sigma_{X} \cdot \sigma_{Y}} \in [-1, 1]

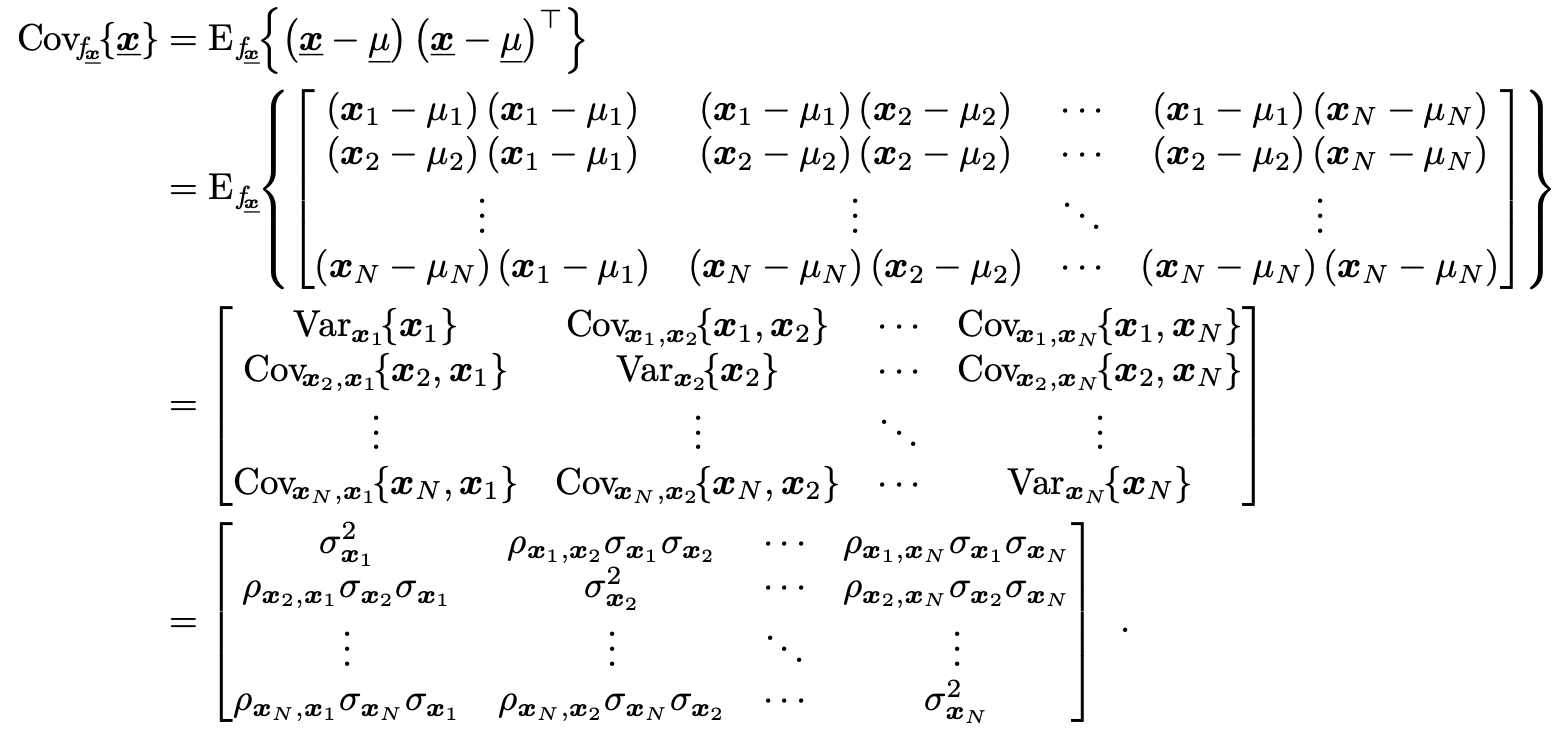

ρ X , Y = Var f X { X } Var f Y { Y } Cov f X , Y { X , Y } = σ X ⋅ σ Y σ X , Y ∈ [ − 1 , 1 ] stellt ein Ähnlichkeitsmaß der Zufallsvariablen X X X Y Y Y ∣ ρ X , Y ∣ = 1 \left|\rho_{X, Y}\right|=1 ∣ ρ X , Y ∣ = 1 X X X Y Y Y ∣ ρ X , Y ∣ = 0 \left|\rho_{X, Y}\right|=0 ∣ ρ X , Y ∣ = 0 X X X Y Y Y i.e. , X X X Y Y Y unkorreliert )Unabhängige Zufallsvariablen sind unkorreliert. (Die Umkehrung dieser Aussage gilt im allgemeinen NICHT!) Haben X X X Y Y Y [ X , Y ] ⊤ [X, Y]^\top [ X , Y ] ⊤ ρ X , Y = 0 \rho_{X, Y} = 0 ρ X , Y = 0 X X X Y Y Y Ist X ‾ = { X 1 , X 2 , … , X N } ⊤ \underline{X}=\left\{X_{1}, X_{2}, \ldots, X_{N}\right\}^{\top} X = { X 1 , X 2 , … , X N } ⊤ N N N Kovarianzmatrix ist

Cov f x ‾ { X ‾ } = E f x ‾ ‾ { ( X ‾ − μ ‾ ) ( X ‾ − μ ‾ ) ⊤ } = [ Var X 1 { X 1 } Cov X 1 , X 2 { X 1 , X 2 } ⋯ Cov X 1 , X N { X 1 , X N } Cov X 2 , X 1 { X 2 , X 1 } Var X 2 { X 2 } ⋯ C o v X 2 , X N { X 2 , X N } ⋮ ⋮ ⋱ ⋮ Cov X N , X 1 { X N , X 1 } Cov X N , X 2 { X N , X 2 } ⋯ Var X N { X N } ] = [ σ X 1 2 ρ X 1 , X 2 σ X 1 σ X 2 ⋯ ρ X 1 , X N σ X 1 σ X N ρ X 2 , X 1 σ X 2 σ X 1 σ X 2 2 ⋯ ρ X 2 , X N σ X 2 σ X N ⋮ ⋮ ⋱ ⋮ ρ X N , X 1 σ X N σ X 1 ρ X N , X 2 σ X N σ X 2 ⋯ σ X N 2 ]

\begin{array}{l}

\operatorname{Cov}_{f_{\underline{x}}}\{\underline{X}\}=\mathrm{E}_{f_{\underline{\underline{x}}}}\left\{(\underline{X}-\underline{\mu})(\underline{X}-\underline{\mu})^{\top}\right\}\\

\newline

=\left[\begin{array}{cccc}

\operatorname{Var}_{X_{1}}\left\{X_{1}\right\} & \operatorname{Cov}_{X_{1}, X_{2}}\left\{X_{1}, X_{2}\right\} & \cdots & \operatorname{Cov}_{X_{1}, X_{N}}\left\{X_{1}, X_{N}\right\} \\

\operatorname{Cov}_{X_{2}, X_{1}}\left\{X_{2}, X_{1}\right\} & \operatorname{Var}_{X_{2}}\left\{X_{2}\right\} & \cdots & \mathrm{Cov}_{X_{2}, X_{N}}\left\{X_{2}, X_{N}\right\} \\

\vdots & \vdots & \ddots & \vdots \\

\operatorname{Cov}_{X_{N}, X_{1}}\left\{X_{N}, X_{1}\right\} & \operatorname{Cov}_{X_{N}, X_{2}}\left\{X_{N}, X_{2}\right\} & \cdots & \operatorname{Var}_{X_{N}}\left\{X_{N}\right\}

\end{array}\right]\\

\newline

=\left[\begin{array}{cccc}

\sigma_{X_{1}}^{2} & \rho_{X_{1}, X_{2}} \sigma_{X_{1}} \sigma_{X_{2}} & \cdots & \rho_{X_{1}, X_{N}} \sigma_{X_{1}} \sigma_{X_{N}} \\

\rho_{X_{2}, X_{1}} \sigma_{X_{2}} \sigma_{X_{1}} & \sigma_{X_{2}}^{2} & \cdots & \rho_{X_{2}, X_{N}} \sigma_{X_{2}} \sigma_{X_{N}} \\

\vdots & \vdots & \ddots & \vdots \\

\rho_{X_{N}, X_{1}} \sigma_{X_{N}} \sigma_{X_{1}} & \rho_{X_{N}, X_{2}} \sigma_{X_{N}} \sigma_{X_{2}} & \cdots & \sigma_{X_{N}}^{2}

\end{array}\right]

\end{array}

Cov f x { X } = E f x { ( X − μ ) ( X − μ ) ⊤ } = Var X 1 { X 1 } Cov X 2 , X 1 { X 2 , X 1 } ⋮ Cov X N , X 1 { X N , X 1 } Cov X 1 , X 2 { X 1 , X 2 } Var X 2 { X 2 } ⋮ Cov X N , X 2 { X N , X 2 } ⋯ ⋯ ⋱ ⋯ Cov X 1 , X N { X 1 , X N } Cov X 2 , X N { X 2 , X N } ⋮ Var X N { X N } = σ X 1 2 ρ X 2 , X 1 σ X 2 σ X 1 ⋮ ρ X N , X 1 σ X N σ X 1 ρ X 1 , X 2 σ X 1 σ X 2 σ X 2 2 ⋮ ρ X N , X 2 σ X N σ X 2 ⋯ ⋯ ⋱ ⋯ ρ X 1 , X N σ X 1 σ X N ρ X 2 , X N σ X 2 σ X N ⋮ σ X N 2 Detail Eine Kovarianzmatrix ist stets symmetrisch und positiv definit (oder positiv semidefinit).