Berechnung der Momente: Unscented Kalman Filter (UKF) Analytische Momente Scheinbar die beste Methode, da schnell & feste Laufzeit 👍 AberHerleitung aufwändig Formeln werden schnell unhandlich groß Beispiel: Kubisches Sensorproblem (skalar) Output y y y x x x

y = h ( x ) + v = x 3 + v

y=h(x)+v=x^{3}+v

y = h ( x ) + v = x 3 + v Gegeben

Priore Schätzung x p ∼ N ( x ^ p , σ p 2 ) x_p \sim \mathcal{N}(\hat{x}_p, \sigma_p^2) x p ∼ N ( x ^ p , σ p 2 ) Messung y ^ \hat{y} y ^ Rauschen v v v E { v } = 0 , Cov { v } = Z v 2 E\{v\}=0, \operatorname{Cov}\{v\}=Z_{v}^{2} E { v } = 0 , Cov { v } = Z v 2 Definiere

z : = [ x y ] ⇒ E { z ‾ } = [ x ^ p E { h ( x ) } ]

z := \left[\begin{array}{l}

x \\

y

\end{array}\right] \Rightarrow E\{\underline{z}\}=\left[\begin{array}{c}

\hat{x}_{p} \\

E\{h(x)\}

\end{array}\right]

z := [ x y ] ⇒ E { z } = [ x ^ p E { h ( x )} ] mit

E { h ( x ) } = ∫ R h ( x ) f p ( x ) d x = ∫ R x 3 f p ( x ) d x = x ^ p 2 + 3 x ^ p σ p 2 = : E 3

E\{h(x)\}=\int_{\mathbb{R}} h(x) f_{p}(x) d x=\int_{\mathbb{R}} x^{3} f_{p}(x) d x=\hat{x}_{p}^{2}+3 \hat{x}_{p} \sigma_{p}^{2}=:E_{3}

E { h ( x )} = ∫ R h ( x ) f p ( x ) d x = ∫ R x 3 f p ( x ) d x = x ^ p 2 + 3 x ^ p σ p 2 =: E 3 Definiere

h ˉ ( x ) = h ( x ) − E { h ( x ) }

\bar{h}(x)=h(x)-E\{h(x)\}

h ˉ ( x ) = h ( x ) − E { h ( x )} Dann

Cov { z ‾ } = [ C x x C x y C y x C y y ] = [ σ p 2 E { ( x − x ^ p ) h ˉ ( x ) } E { ( x − x ^ p ) h ˉ ( x ) } E { h ‾ 2 ( x ) } + σ v 2 ]

\operatorname{Cov}\{\underline{z}\}=\left[\begin{array}{ll}

\mathbf{C}_{x x} & \mathbf{C}_{x y} \\

\mathbf{C}_{y x} & \mathbf{C}_{y y}

\end{array}\right]=\left[\begin{array}{cc}

\sigma_{p}^{2} & E\left\{\left(x-\hat{x}_{p}\right) \bar{h}(x)\right\} \\

E\left\{\left(x-\hat{x}_{p}\right) \bar{h}(x)\right\} & E\left\{\overline{h}^{2}(x)\right\}+\sigma_{v}^{2}

\end{array}\right]

Cov { z } = [ C xx C y x C x y C yy ] = [ σ p 2 E { ( x − x ^ p ) h ˉ ( x ) } E { ( x − x ^ p ) h ˉ ( x ) } E { h 2 ( x ) } + σ v 2 ] E { ( x − x ^ p ) h ˉ ( x ) } = E { ( x − x ^ p ) ( x 3 − E 3 ) } = E { x 4 − x ^ p x 3 − E 3 x + x ^ p E 3 } = E 4 − x ^ p E 3 − E 3 x ^ p + x ^ p E 3 = E 4 − x ^ p E 3

\begin{aligned}

E\left\{\left(x-\hat{x}_{p}\right)\bar{h}(x)\right\} &= E\left\{\left(x-\hat{x}_{p}\right)\left(x^{3}-E_{3}\right)\right\} \\

&= E\left\{x^{4}-\hat{x}_{p} x^{3}-E_{3} x+\hat{x}_{p} E_{3}\right\} \\

&= E_4 - \hat{x}_p E_3 - E_3 \hat{x}_p + \hat{x}_p E_3 \\

&= E_4 - \hat{x}_p E_3

\end{aligned}

E { ( x − x ^ p ) h ˉ ( x ) } = E { ( x − x ^ p ) ( x 3 − E 3 ) } = E { x 4 − x ^ p x 3 − E 3 x + x ^ p E 3 } = E 4 − x ^ p E 3 − E 3 x ^ p + x ^ p E 3 = E 4 − x ^ p E 3 mit

E q = x ^ p 4 + 6 x ^ p 2 σ p 2 + 3 σ p 4 = x ^ p 4 + 6 x ^ p 2 2 p 2 + 3 σ p 4 − x ^ p 4 − 3 x ^ p 2 σ p 2 = 3 σ p 4 + 3 x ^ p 2 σ p 2 = 3 σ p 2 ( x ^ p 2 + 2 p 2 )

\begin{aligned}

E_{q}&=\hat{x}_{p}^{4}+6 \hat{x}_{p}^{2} \sigma_{p}^{2}+3\sigma_{p}^{4} \\\\

&=\hat{x}_{p}^{4}+6 \hat{x}_{p}^{2} 2_{p}^{2}+3\sigma_{p}^{4}-\hat{x}_{p}^{4}-3 \hat{x}_{p}^{2} \sigma_{p}^{2} \\\\

&=3 \sigma_{p}^{4}+3 \hat{x}_{p}^{2} \sigma_{p}^{2} \\\\

&=3\sigma_{p}^{2}\left(\hat{x}_{p}^{2}+2_{p}^{2}\right)

\end{aligned}

E q = x ^ p 4 + 6 x ^ p 2 σ p 2 + 3 σ p 4 = x ^ p 4 + 6 x ^ p 2 2 p 2 + 3 σ p 4 − x ^ p 4 − 3 x ^ p 2 σ p 2 = 3 σ p 4 + 3 x ^ p 2 σ p 2 = 3 σ p 2 ( x ^ p 2 + 2 p 2 ) und

E { h ˉ 2 ( x ) } = 9 x ^ p 4 σ p 2 + 36 x ^ p 2 σ p 4 + 15 σ p 6

E\left\{\bar{h}^{2}(x)\right\}=9 \hat{x}_{p}^{4} \sigma_{p}^{2}+36 \hat{x}_{p}^{2} \sigma_{p}^{4}+15\sigma_{p}^{6}

E { h ˉ 2 ( x ) } = 9 x ^ p 4 σ p 2 + 36 x ^ p 2 σ p 4 + 15 σ p 6 In der Kalmanfilter Filterungsgleichung einsetzen ergibt sich

x ^ e = x ^ p + C x y C y y − 1 ( y ^ − E { h ( x ) } ) = skalar x ^ p + C x y C y y ( y ^ − E { h ( x ) } ) σ y 2 = σ p 2 − C x y C y y − 1 C y x = skalar σ p 2 − C x y 2 C y y

\begin{array}{l}

\hat{x}_{e}=\hat{x}_{p}+\mathbf{C}_{xy}\mathbf{C}_{yy}^{-1}(\hat{y}-E\{h(x)\}) \overset{\text{skalar}}{=} \hat{x}_{p}+\frac{\mathbf{C}_{x y}}{\mathbf{C}_{y y}}(\hat{y}-E\{h(x)\}) \\

\sigma_{y}^{2}= \sigma_{p}^{2}-\mathbf{C}_{xy}\mathbf{C}_{yy}^{-1}\mathbf{C}_{yx} \overset{\text{skalar}}{=} \sigma_{p}^{2}-\frac{\mathbf{C}_{x y}^{2}}{\mathbf{C}_{y y}}

\end{array}

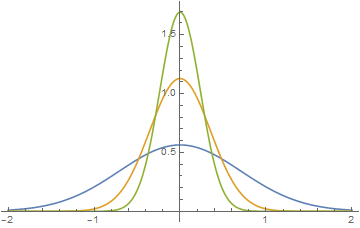

x ^ e = x ^ p + C x y C yy − 1 ( y ^ − E { h ( x )}) = skalar x ^ p + C yy C x y ( y ^ − E { h ( x )}) σ y 2 = σ p 2 − C x y C yy − 1 C y x = skalar σ p 2 − C yy C x y 2 Einschub: Momente Gaußdichte Theorem

Die zentralen Momente einer Gaußdichte sind gegeben durch

$$

C\_{i}=E\_{f}\left\\{(\boldsymbol{x}-\hat{x})^{i}\right\\}=\left\\{\begin{array}{ll}

\displaystyle\prod\_{j=1, j\text{ ungeradde}}^{i-1} j \sigma^{i}=1 \cdot 3 \cdot 5 \cdots(i-1) \sigma^{i} & i \text { gerade } \\\\

0 & i \text { ungerade }

\end{array}\right.

$$

Numerische Momente Basierend auf Abtastwerten der prioren Dichte Approximation der Prioren Gaußdichte durch Samples

Verschiedene Verfahren mit unterschiedliche Komplexität, Effizienz, Genauigkeit

Zufälliges Sampling mit Zufallszahlengenerator → \rightarrow →

Abtastung (z.B. äquidistantes Gitter)

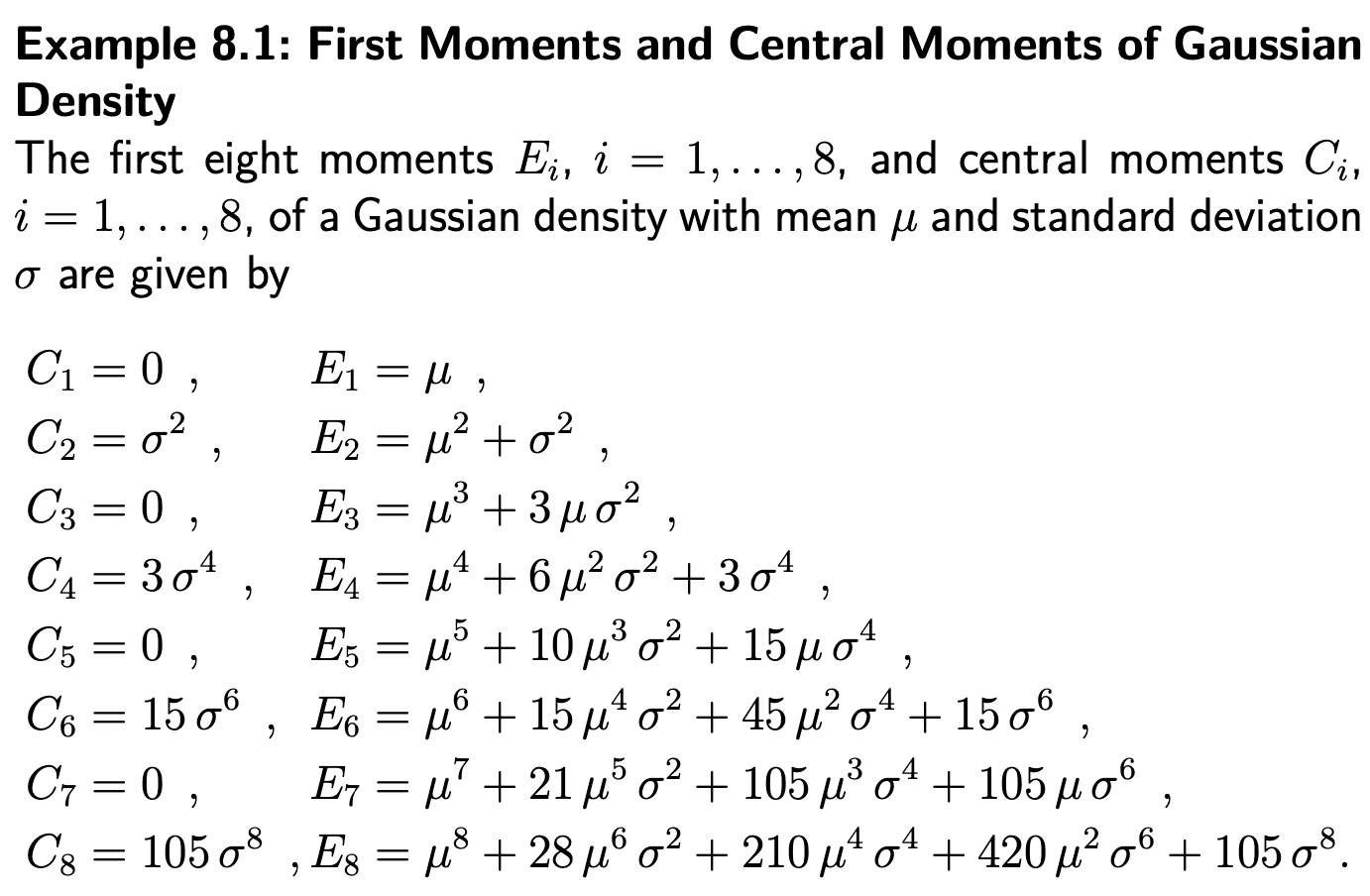

Minimale Approximation auf den Hauptachsen

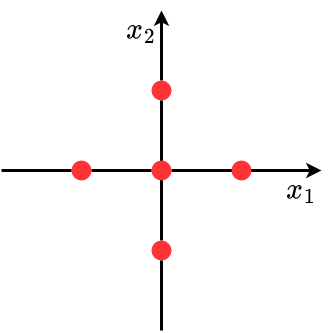

Genaue Approximation auf den Hauptachsen

Allgemeine Sample-Approximation → \rightarrow →

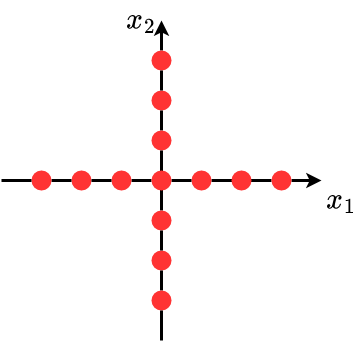

Einschub: Diracsche Deltafunktion Betrachtung Grenzfall einer Gaußdichte

f ( x , m , σ ) = 1 2 π σ exp { − 1 2 ( x − m ) 2 σ 2 }

f(x, m, \sigma)=\frac{1}{\sqrt{2 \pi} \sigma} \exp \left\{-\frac{1}{2} \frac{(x-m)^{2}}{\sigma^{2}}\right\}

f ( x , m , σ ) = 2 π σ 1 exp { − 2 1 σ 2 ( x − m ) 2 } für σ → 0 \sigma \rightarrow 0 σ → 0

Plotting verschiedener Gaußdichte für m = 0 m=0 m = 0

Dirasche Deltafunktion

δ ( x − m ) = lim σ → 0 f ( x , m , σ )

\delta(x-m)=\lim _{\sigma \rightarrow 0} f(x, m, \sigma)

δ ( x − m ) = σ → 0 lim f ( x , m , σ ) Wenn die Bereite gegen 0 (σ → 0 \sigma \to 0 σ → 0

∫ − ∞ ∞ δ ( x − m ) d x = 1

\int_{-\infty}^{\infty} \delta(x-m) d x=1

∫ − ∞ ∞ δ ( x − m ) d x = 1 Definition : Diracsche Deltafunktion

$$

\delta(x)=\left\\{\begin{array}{cc}

\text{Nicht definiert} & x=0 \\\\

0 & \text { sonst }

\end{array}\right.

$$

$$

\int_{-\infty}^{\infty} \delta(x) d x=\int_{-\varepsilon}^{\varepsilon} \delta(x) d x=1, \varepsilon>0

$$Laut Definition hat die Dirasche Deltafunktion alle Eigenschaften einer Dichte Wichtige Eigenschaftenf ( x ) ⋅ δ ( x − m ) = f ( m ) δ ( x − m ) f(x) \cdot \delta(x-m)=f(m) \delta(x-m) f ( x ) ⋅ δ ( x − m ) = f ( m ) δ ( x − m ) ∫ R f ( x ) δ ( x − m ) d x = f ( m ) \int_{\mathbb{R}} f(x) \delta(x-m) d x=f(m) ∫ R f ( x ) δ ( x − m ) d x = f ( m ) Heaviside Funktion (Unit Step Function) Cumulative Verteilungsfunktion der Gaußdichte

F ( x ) = P ( x ≤ x ) = ∫ − ∞ x f ( x ) d x = 1 2 { 1 + erf ( x − m 2 σ ) }

F(x)=P(\boldsymbol{x} \leq x)=\int_{-\infty}^{x} f(x) d x=\frac{1}{2}\left\{1+\operatorname{erf}\left(\frac{x-m}{\sqrt{2} \sigma}\right)\right\}

F ( x ) = P ( x ≤ x ) = ∫ − ∞ x f ( x ) d x = 2 1 { 1 + erf ( 2 σ x − m ) } Es gilt

f ( x ) = d d x F ( x )

f(x)=\frac{d}{d x} F(x)

f ( x ) = d x d F ( x ) Definition : Heaviside Funktion

$$

H(x-m)=\lim\_{\sigma \to 0} F(x)=\left\\{\begin{array}{ll}

1 & x>m \\\\

\frac{1}{2} & x=m \\\\

0 & xCumulative Verteilungsfunktion von δ ( x ) \delta(x) δ ( x ) H ( x ) H(x) H ( x )

H ( x ) = ∫ − ∞ x δ ( x ) d x δ ( x ) = d d x H ( x )

\begin{array}{l}

H(x)=\displaystyle\int_{-\infty}^{x} \delta(x) d x \\\\

\delta(x)=\frac{d}{d x} H(x)

\end{array}

H ( x ) = ∫ − ∞ x δ ( x ) d x δ ( x ) = d x d H ( x ) Multivariate Diracsche Deltafunktion Dirasche Mischdichten (Dirac Mixture)

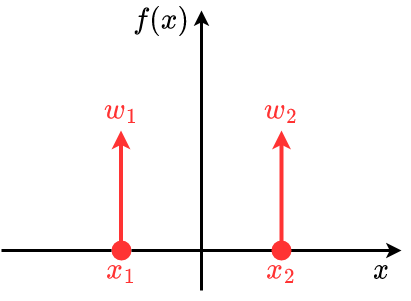

f ( x ) = ∑ i = 1 L ω i δ ( x − x i )

f(x)=\sum_{i=1}^{L} \omega_{i} \delta \left(x-x_{i}\right)

f ( x ) = i = 1 ∑ L ω i δ ( x − x i ) Multivariate Diracdichte

δ ( x ‾ ) = δ ( x 1 ) ⋅ δ ( x 2 ) ⋅ … , x ‾ = [ x 1 , x 2 , … ] ⊤

\delta(\underline{x})=\delta\left(x_{1}\right) \cdot \delta\left(x_{2}\right) \cdot \ldots, \quad \underline{x}=\left[x_{1}, x_{2}, \ldots\right]^{\top}

δ ( x ) = δ ( x 1 ) ⋅ δ ( x 2 ) ⋅ … , x = [ x 1 , x 2 , … ] ⊤ Multivariate Dirasche Mischdichte

f ( x ‾ ) = ∑ i = 1 L ω i δ ( x ‾ − x ‾ i )

f(\underline{x})=\sum_{i=1}^{L} \omega_{i} \delta\left(\underline{x}-\underline{x}_{i}\right)

f ( x ) = i = 1 ∑ L ω i δ ( x − x i ) Umrechnung SNV → \rightarrow → (SNV = Standard Normalverteilung N ( 0 , 1 ) \mathcal{N}(0, 1) N ( 0 , 1 )

Natürliche Lösung für Problem Verschiedene Möglichkeiten mit unterschiedlicher Komplexität und Effizienz Angenommen: Wir haben ein Approximationsverfahren, das eine standardverteilung in merh-/höher-dimension approximieren kann.

Gegeben: Gaußdichte mit x ^ ‾ = 0 ‾ \underline{\hat{x}}=\underline{0} x ^ = 0 C x = I N \mathbf{C}_x = \mathbf{I}_N C x = I N N N N Gesucht: Dichte mit beliebigen Mittelwert y ^ ‾ \underline{\hat{y}} y ^ C y \mathbf{C}_y C y Wir machen Cholesky-Zerlegung

C y = C y ⋅ C y ⊤

\mathbf{C}_{y}=\mathcal{C}_{y} \cdot \mathcal{C}_{y}^{\top}

C y = C y ⋅ C y ⊤ wobei C y \mathcal{C}_y C y

Umrechnung

y ‾ = C y ⋅ x ‾ + y ^ ‾

\underline{y}=\mathcal{C}_{y} \cdot \underline{x}+\underline{\hat{y}}

y = C y ⋅ x + y ^ Beweis:

E { y ‾ } = E { C y ⋅ x ‾ + y ^ } = C y E { x ‾ } ⏟ = 0 ‾ + E { y ^ ⏟ = y ‾ } = y ^ ‾

E\{\underline{y}\}=E\left\{\mathcal{C}_{y} \cdot \underline{x}+\hat{y}\right\}=\mathcal{C}_{y} \underbrace{E\{\underline{x}\}}_{=\underline{0}}+\underbrace{E\{\hat{y}}_{=\underline{y}}\}=\underline{\hat{y}}

E { y } = E { C y ⋅ x + y ^ } = C y = 0 E { x } + = y E { y ^ } = y ^ Cov { y ‾ } = E { ( y ‾ − E { y ‾ } ) ( y ‾ − E { y ‾ ) ⊤ } = E { ( y ‾ − y ^ ‾ ) ( y ‾ − y ^ ‾ ) ⊤ } = E { C y ⋅ x ‾ ⋅ x ‾ ⊤ C y ⊤ } = C y ⋅ E { x ‾ x ‾ ⊤ } ⏟ = C x = I N ⋅ C y ⊤ = C y ⋅ I N ⋅ C y ⊤ = C y ⋅ C y ⊤ = C y

\begin{aligned}

\operatorname{Cov}\{\underline{y}\} &=E\left\{(\underline{y}-E\{\underline{y}\})(\underline{y}-E\{\underline{y})^{\top}\right\} \\

&=E\left\{(\underline{y}-\underline{\hat{y}})(\underline{y}-\underline{\hat{y}})^{\top}\right\} \\

&=E\left\{\mathcal{C}_{y} \cdot \underline{x} \cdot \underline{x}^{\top} \mathcal{C}_{y}^{\top}\right\}\\

&=\mathcal{C}_{y} \cdot \underbrace{E\left\{\underline{x}\underline{x}^{\top}\right\}}_{=\mathbf{C}_{x}=\mathbf{I}_{N}} \cdot \mathcal{C}{y}^{\top} \\

&=\mathcal{C}_{y} \cdot \mathbf{I}_{N} \cdot \mathcal{C}_{y}^{\top}=\mathcal{C}_{y} \cdot \mathcal{C}_{y}^{\top} = \mathbf{C}_{y}

\end{aligned}

Cov { y } = E { ( y − E { y }) ( y − E { y ) ⊤ } = E { ( y − y ^ ) ( y − y ^ ) ⊤ } = E { C y ⋅ x ⋅ x ⊤ C y ⊤ } = C y ⋅ = C x = I N E { x x ⊤ } ⋅ C y ⊤ = C y ⋅ I N ⋅ C y ⊤ = C y ⋅ C y ⊤ = C y Minimale Approximation SNV auf Hauptachsen 1D-Fall

Die wahre Dichte f ~ ( x ) \tilde{f}(x) f ~ ( x )

f ( x ) = w 1 δ ( x − x 1 ) + w 2 δ ( x − x 2 ) w 1 , w 2 ⩾ 0

f(x)=w_{1} \delta\left(x-x_{1}\right)+w_{2} \delta\left(x-x_{2}\right) \qquad w_{1}, w_{2} \geqslant 0

f ( x ) = w 1 δ ( x − x 1 ) + w 2 δ ( x − x 2 ) w 1 , w 2 ⩾ 0 Gaußdichte ist symmetrisch ⇒ \Rightarrow ⇒

w 1 = w 2 = w , x 1 = − x 2

w_{1}=w_{2}=w, \quad x_{1}=-x_{2}

w 1 = w 2 = w , x 1 = − x 2 Integral soll gleich 1 sein.

∫ R f ( x ) d x = w 1 + w 2 = 2 w = ! 1 ⇒ w = 1 2

\int_{\mathbb{R}} f(x) d x=w_{1}+w_{2}=2 w \stackrel{!}{=} 1 \Rightarrow w=\frac{1}{2}

∫ R f ( x ) d x = w 1 + w 2 = 2 w = ! 1 ⇒ w = 2 1 Erwartungswert:

E f { x } = 0 = E f ~ { x }

E_{f}\{x\}=0=E_{\tilde{f}}\{x\}

E f { x } = 0 = E f ~ { x } Varianz:

E f { x 2 } = ∫ R x 2 f ( x ) d x = w x 1 2 + w x 2 2 = 2 w x 1 2 = ! 1 ⇒ x 1 2 = 1 ⇒ x 1 = − 1 , x 2 = 1

E_{f}\left\{x^{2}\right\}=\int_{\mathbb{R}} x^{2} f(x) d x=w x_{1}^{2}+w x_{2}^{2}=2 w x_{1}^{2} \stackrel{!}{=} 1 \Rightarrow x_{1}^{2}=1 \Rightarrow x_1 = -1, x_2 = 1

E f { x 2 } = ∫ R x 2 f ( x ) d x = w x 1 2 + w x 2 2 = 2 w x 1 2 = ! 1 ⇒ x 1 2 = 1 ⇒ x 1 = − 1 , x 2 = 1 2D-Fall

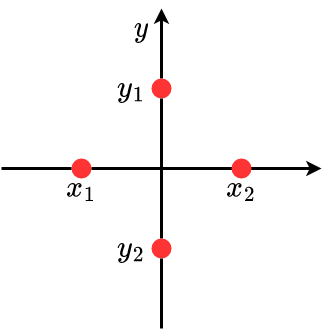

f ( x , y ) = w 1 δ ( x − x 1 ) δ ( y ) + w 2 δ ( x − x 2 ) δ ( y ) w 1 , w 2 ⩾ 0 + v 1 δ ( x ) δ ( y − y 1 ) + v 2 δ ( x ) δ ( y − y 2 ) v 1 , v 2 ⩾ 0

\begin{aligned}

f(x, y)=& w_{1} \delta\left(x-x_{1}\right) \delta(y)+w_{2} \delta\left(x-x_{2}\right) \delta(y) & w_{1}, w_{2} \geqslant 0 \\

&+v_{1} \delta(x) \delta\left(y-y_{1}\right)+v_{2} \delta(x) \delta\left(y-y_{2}\right) & v_{1}, v_{2} \geqslant 0

\end{aligned}

f ( x , y ) = w 1 δ ( x − x 1 ) δ ( y ) + w 2 δ ( x − x 2 ) δ ( y ) + v 1 δ ( x ) δ ( y − y 1 ) + v 2 δ ( x ) δ ( y − y 2 ) w 1 , w 2 ⩾ 0 v 1 , v 2 ⩾ 0 Symmetrie ⇒ \Rightarrow ⇒

w 1 = w 2 = v 1 = v 2 = w , x 1 = − x 2 , v 1 = − y 2

w_{1}=w_{2}=v_{1}=v_{2}=w, \quad x_{1}=-x_{2}, \quad v_{1}=-y_{2}

w 1 = w 2 = v 1 = v 2 = w , x 1 = − x 2 , v 1 = − y 2 Integral = 1

∫ R 2 f ( x , y ) d x d y = w { ∫ R s ( x − x 1 ) d x ∫ R f ( y ) d y + … } = 4 w = ! 1 ⇒ w = 1 4

\int_{\mathbb{R}^{2}} f(x, y) d x d y=w\left\{\int_{\mathbb{R}} s\left(x-x_{1}\right) d x \int_{\mathbb{R}} f(y) d y+\ldots\right\}=4 w \stackrel{!}{=} 1 \Rightarrow w=\frac{1}{4}

∫ R 2 f ( x , y ) d x d y = w { ∫ R s ( x − x 1 ) d x ∫ R f ( y ) d y + … } = 4 w = ! 1 ⇒ w = 4 1 Varianz

∬ R x 2 f ( x , y ) d x d y = w x 1 2 + w x 2 2 = 2 w x 1 2 = ! 1 ⇒ x 1 2 = 2 ⇒ x 1 = − 2 , x 2 = 2

\iint_{\mathbb{R}} x^{2} f(x, y) d x d y=w x_{1}^{2}+w x_{2}^{2}=2 w x_{1}^{2} \stackrel{!}{=} 1 \Rightarrow x_{1}^{2}=2 \Rightarrow x_1 = -\sqrt{2}, x_2 = \sqrt{2}

∬ R x 2 f ( x , y ) d x d y = w x 1 2 + w x 2 2 = 2 w x 1 2 = ! 1 ⇒ x 1 2 = 2 ⇒ x 1 = − 2 , x 2 = 2 x , y x, y x , y

f ( x , y ) ≠ f ( x ) ⋅ f ( y ) , E { x ⋅ y } = 0

f(x, y) \neq f(x) \cdot f(y), E\{x \cdot y\}=0

f ( x , y ) = f ( x ) ⋅ f ( y ) , E { x ⋅ y } = 0 N-dim Fall

w = 1 2 N x ‾ = [ x ( 1 ) , x ( 2 ) , … ] ⊤ ⇒ x 1 ( i ) = − N , x 2 ( i ) = + N , i = 1 , … , N

\begin{array}{c}

w=\frac{1}{2 N} \quad \underline{x}=\left[x^{(1)}, x^{(2)}, \ldots\right]^{\top} \\

\Rightarrow \begin{equation}

x_{1}^{(i)}=-\sqrt{N}, \quad x_{2}^{(i)}=+\sqrt{N}, \quad i=1, \ldots, N

\end{equation}

\end{array}

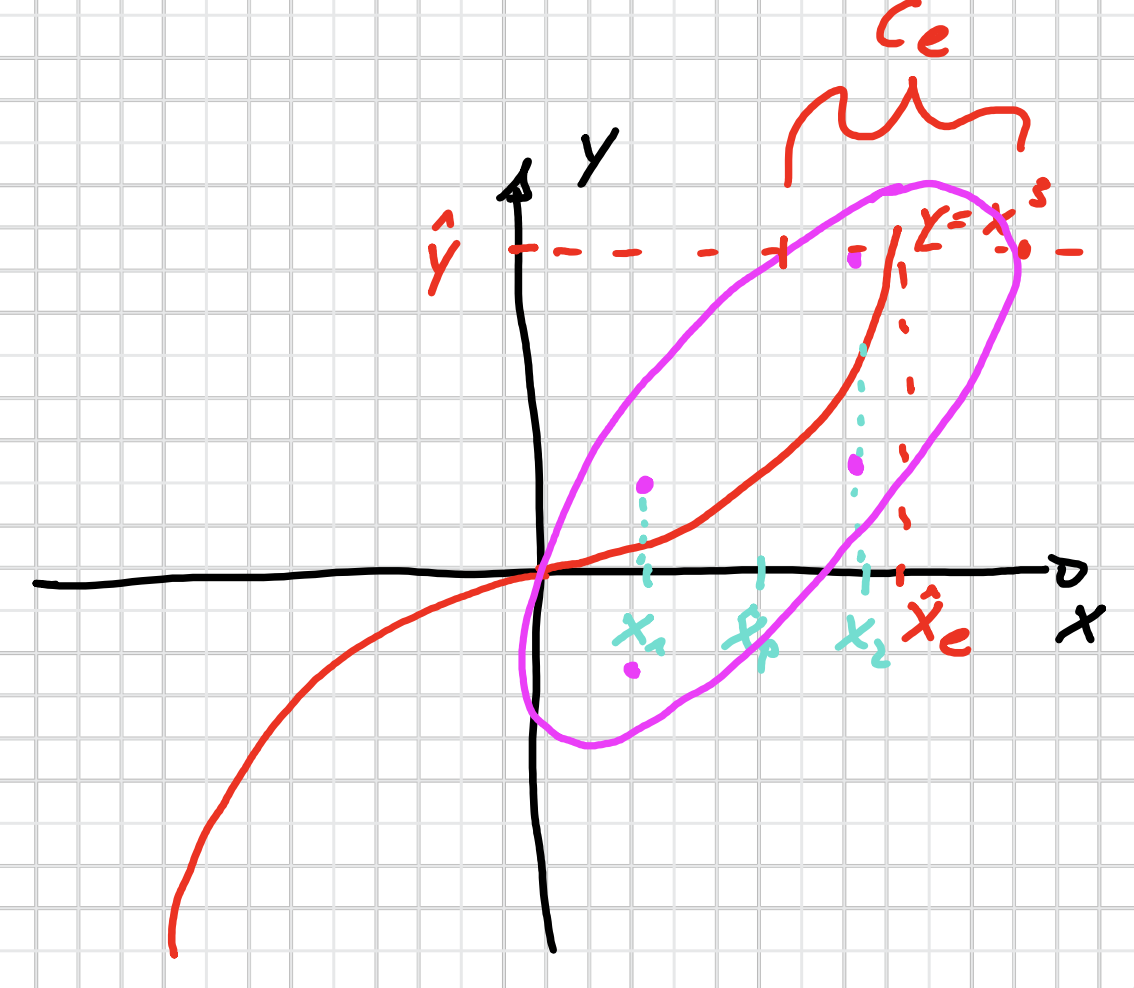

w = 2 N 1 x = [ x ( 1 ) , x ( 2 ) , … ] ⊤ ⇒ x 1 ( i ) = − N , x 2 ( i ) = + N , i = 1 , … , N Ablauf des Filters mit Sampling der prioren Dichte Messfunktion (Bsp.)

y = x 3 + v

y = x^3 + v

y = x 3 + v Priore Schätzung: Gaußdichte f ~ p ( x ) = N ( x , x ^ p , σ p 2 ) \tilde{f}_{p}(x)=\mathcal{N}\left(x, \hat{x}_{p}, \sigma_{p}^{2}\right) f ~ p ( x ) = N ( x , x ^ p , σ p 2 )

Rauschen: v ∼ f ~ v ( v ) = N ( v , 0 , σ v 2 ) v \sim \tilde{f}_v(v) = \mathcal{N}(v, 0, \sigma_v^2) v ∼ f ~ v ( v ) = N ( v , 0 , σ v 2 )

Approximation

f p ( x ) = 1 2 δ ( x − x 1 ) + 1 2 δ ( x − x 2 )

f_{p}(x)=\frac{1}{2} \delta\left(x-x_{1}\right)+\frac{1}{2} \delta\left(x-x_{2}\right)

f p ( x ) = 2 1 δ ( x − x 1 ) + 2 1 δ ( x − x 2 ) wobei

x 1 = x ^ p − σ p x 2 = x ^ p + σ p

x_1 = \hat{x}_p - \sigma_p \quad x_2 = \hat{x}_p + \sigma_p

x 1 = x ^ p − σ p x 2 = x ^ p + σ p f v ( v ) = 1 2 δ ( x − σ v ⏟ = v 1 ) + 1 2 δ ( x + σ v ⏟ = v 2 )

f_v(v)=\frac{1}{2} \delta(\underbrace{x - \sigma_{v}}_{=v_{1}})+\frac{1}{2} \delta(\underbrace{x+\sigma_{v}}_{=v_{2}})

f v ( v ) = 2 1 δ ( = v 1 x − σ v ) + 2 1 δ ( = v 2 x + σ v ) Dann

y i j = x i 3 + v j i = 1 , 2 , j = 1 , 2

y_{i j}=x_{i}^{3}+v_{j} \qquad i=1,2 , j=1,2

y ij = x i 3 + v j i = 1 , 2 , j = 1 , 2 Wir sampeln für x x x v v v ( x , y ) (x, y) ( x , y ) ( x 1 , y 11 ) , ( x 1 , y 12 ) , ( x 2 , y 21 ) , ( x 2 , y 22 ) (x_1, y_{11}), (x_1, y_{12}), (x_2, y_{21}), (x_2, y_{22}) ( x 1 , y 11 ) , ( x 1 , y 12 ) , ( x 2 , y 21 ) , ( x 2 , y 22 )

Wir nehmen an, dass x , y x, y x , y

Wir haben auch die Messung y ^ \hat{y} y ^ y ^ \hat{y} y ^